Kardinalli –њ–Є—Б–∞–ї(–∞):–Р –њ–Њ—З–µ–Љ—Г? –ѓ –і–µ–є—Б—В–≤–Є—В–µ–ї—М–љ–Њ —Е–Њ—З—Г –≤—Л–±—А–∞—В—М –Њ–њ—В–Є–Љ–∞–ї—М–љ—Л–є –≤–∞—А–Є–∞–љ—В.

–Р –њ–Њ—В–Њ–Љ—Г, —З—В–Њ DoEvents —Б–ї–Є—И–Ї–Њ–Љ —В—П–ґ–µ–ї–Њ–≤–µ—Б–љ–∞—П —Д—Г–љ–Ї—Ж–Є—П, –Є –њ–Њ–Љ–Є–Љ–Њ –Њ–і–Є–љ–Њ—З–љ–Њ–є –њ—А–Њ–Ї–∞—З–Ї–Є –Њ—З–µ—А–µ–і–Є —Б–Њ–Њ–±—Й–µ–љ–Є–є –≤—Л–њ–Њ–ї–љ—П–µ—В —А—П–і –ї–Є—И–љ–Є—Е —В—П–ґ–µ–ї—Л—Е –і–µ–є—Б—В–≤–Є–є, –љ–Њ, —З—В–Њ –µ—Й—С —Е—Г–ґ–µ вАФ DoEvents –љ–µ –Њ–±–µ—Б–њ–µ—З–Є–≤–∞–µ—В –Ј–∞–Љ–Њ—А–∞–ґ–Є–≤–∞–љ–Є–Є –њ–Њ—В–Њ–Ї–∞ –і–Њ –њ—А–Є—Е–Њ–і–∞ –±–ї–Є–ґ–∞–є—И–µ–≥–Њ —Б–Њ–Њ–±—Й–µ–љ–Є—П, –∞ –≤—Л–њ–Њ–ї–љ–Є–≤ —В—П–ґ–µ–ї–Њ–≤–µ—Б–љ—Л–µ –Ј–∞–і–∞—З–Є, –≤–Њ–Ј–≤—А–∞—Й–∞–µ—В —Г–њ—А–∞–≤–ї–µ–љ–Є–µ —Б—А–∞–Ј—Г –ґ–µ. –С—Г–і—Г—З–Є –Ј–∞—Б—Г–љ—Г—В–Њ–є –≤ —Ж–Є–Ї–ї, –Њ–љ–∞ –Њ–±–µ—Б–њ–µ—З–Є–≤–∞–µ—В –Ј–∞–≥—А—Г–Ј–Ї—Г –¶–Я –њ–Њ–і 100%.

–° –Є–і–µ–Њ–ї–Њ–≥–Є—З–µ—Б–Ї–Њ–є —В–Њ—З–Ї–Є –Ј—А–µ–љ–Є—П —Н—В–Њ —В–∞–Ї–ґ–µ –љ–µ–≤–µ—А–љ–Њ, –њ–Њ—В–Њ–Љ—Г —З—В–Њ –Њ–і–Є–љ —Ж–Є–Ї–ї —Г–ґ–µ –µ—Б—В—М (–њ–Њ–і –Ї–∞–њ–Њ—В–Њ–Љ), –Є –љ–µ—В –љ–Є–Ї–∞–Ї–Њ–≥–Њ —Б–Љ—Л—Б–ї–∞ –≥–Њ—А–Њ–і–Є—В—М –µ—Й—С –Є –≤—В–Њ—А–Њ–є, –≤—Л–њ–Њ–ї–љ—П—О—Й–Є–є—Б—П –≤ —А–∞–Љ–Ї–∞—Е –Є—В–µ—А–∞—Ж–Є–Є –≤–љ–µ—И–љ–µ–≥–Њ. –Ъ—А–Њ–Љ–µ —В–Њ–≥–Њ, –µ—Б–ї–Є –њ–Њ–љ–∞–і–Њ–±–Є—В—Б—П –Њ–ґ–Є–і–∞—В—М –љ–µ—Б–Ї–Њ–ї—М–Ї–Њ –њ—А–Њ—Ж–µ—Б—Б–Њ–≤, –≤ —В–≤–Њ—С–Љ —Б–ї—Г—З–∞–µ —Н—В–Њ –Њ–±–µ—А–љ—С—В—Б—П –љ–µ—Б–Ї–Њ–ї—М–Ї–Є–Љ–Є —Ж–Є–Ї–ї–∞–Љ–Є, —З—В–Њ –Ї—А–∞–є–љ–µ–є –±–µ—Б—Б–Љ—Л—Б–ї–µ–љ–љ–Њ вАФ¬†–і–Њ–ї–ґ–µ–љ –±—Л—В—М –Њ–і–Є–љ, –Є –Њ—З–µ–љ—М —Е–Њ—А–Њ—И–Њ, —З—В–Њ–±—Л —Н—В–Њ –±—Л–ї —В–Њ—В —Ж–Є–Ї–ї,

–Ї–Њ—В–Њ—А—Л–є —Г–ґ–µ –µ—Б—В—М –Є–Ј–љ–∞—З–∞–ї—М–љ–Њ.

–Ш–і–µ–∞–ї—М–љ—Л–є –≤–∞—А–Є–∞–љ—В, —Н—В–Њ –≤–∞—А–Є–∞–љ—В, –Ї–Њ–≥–і–∞ –µ—Б—В—М –Њ—Б–љ–Њ–≤–љ–Њ–є –њ–Њ—В–Њ–Ї (GUI-–њ–Њ—В–Њ–Ї), –Ї—А—Г—В—П—Й–Є–є —Ж–Є–Ї–ї –њ—А–Њ–Ї–∞—З–Ї–Є —Б–Њ–Њ–±—Й–µ–љ–Є–є (–Ї–∞–Ї –Њ–±—Л—З–љ–Њ), –Є –µ—Б—В—М –ґ–і—Г—Й–Є–є –њ–Њ—В–Њ–Ї, –Ї–Њ—В–Њ—А—Л–є —Б–Є–≥–љ–∞–ї–Є—В –њ–µ—А–≤–Њ–Љ—Г –њ—А–Є –њ–Њ–Љ–Њ—Й–Є —Б–Њ–Њ–±—Й–µ–љ–Є–є. –Т –Љ–Њ—С–Љ —Б–ї—Г—З–∞–µ –≤–Љ–µ—Б—В–Њ —Б–Є–≥–љ–∞–ї–Є–Ј–∞—Ж–Є–Є —Б–Њ–Њ–±—Й–µ–љ–Є—П–Љ–Є –Є—Б–њ–Њ–ї—М–Ј—Г–µ—В—Б—П —Д–ї–∞–≥–Њ–≤—Л–є –њ–Њ–і—Е–Њ–і. –Р–≤—В–Њ—А—Л Wscript.Shell –љ–µ–њ–Њ–љ—П—В–љ–Њ —З–µ–Љ –і—Г–Љ–∞–ї–Є: –Љ–Њ–≥–ї–Є –±—Л —Б–і–µ–ї–∞—В—М —Б–Њ–±—Л—В–Є–µ –Є–Ј–Љ–µ–љ–µ–љ–Є—П —Б—В–∞—В—Г—Б–∞ –њ—А–Њ—Ж–µ—Б—Б–∞, –љ–∞ –Ї–Њ—В–Њ—А–Њ–µ –Љ–Њ–ґ–љ–Њ –њ–Њ–і–њ–Є—Б–∞—В—М—Б—П.

Kardinalli –њ–Є—Б–∞–ї(–∞):–†–∞–±–Њ—В–∞–µ—В –±–µ–Ј –њ—А–Њ–±–ї–µ–Љ, –Ј–∞–Ї—А—Л–≤–∞–µ—В. –Э–µ—В –ї–Є –њ–Њ–і–≤–Њ–і–љ—Л—Е –Ї–∞–Љ–љ–µ–є?

–Э—Г –і–∞, —А–∞–±–Њ—В–∞–µ—В, –љ–Њ —П –±—Л —В–∞–Ї –і–µ–ї–∞—В—М –љ–µ —Б—В–∞–ї –±—Л (–µ—Б–ї–Є –±—Л –њ–Є—Б–∞–ї —З—В–Њ-—В–Њ –Њ—В–ї–Є—З–љ–Њ–µ –Њ—В –≤—А–µ–Љ–µ–љ–љ–Њ–є —Г—В–Є–ї–Є—В–Ї–Є), –∞ –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–ї –±—Л —Б–Њ–Њ—В–≤–µ—В—Б—В–≤—Г—О—Й—Г—О API-—Д—Г–љ–Ї—Ж–Є—О. –Я–Њ–і–≤–Њ–і–љ—Л–µ –Ї–∞–Љ–љ–Є, –Ї–Њ–љ–µ—З–љ–Њ –ґ–µ, –µ—Б—В—М. –Ш –љ–µ –≤–∞–ґ–љ–Њ, –љ–∞ —Б–Ї–Њ–ї—М–Ї–Њ –Љ–∞–ї–Њ–≤–µ—А–Њ—П—В–љ–Њ —В–Њ, —З—В–Њ —П —Б–µ–є—З–∞—Б –Њ–њ–Є—И—Г, –Є–±–Њ –њ–Њ —Б—А–∞–≤–љ–µ–љ–Є—О —Б –≤–µ—А–Њ—П—В–љ–Њ—Б—В—М—О, —З—В–Њ —З—В–Њ-—В–Њ –љ–µ —В–∞–Ї –±—Г–і–µ—В —Б API-—Д—Г–љ–Ї—Ж–Є–µ–є, —Н—В–Є –≤–µ—А–Њ—П—В–љ–Њ—Б—В–Є –≤—Л–≥–ї—П–і—П—В –Њ–≥—А–Њ–Љ–љ—Л–Љ–Є.

–Т–Њ-–њ–µ—А–≤—Л—Е, –љ–∞–±–Њ—А API-—Д—Г–љ–Ї—Ж–Є–µ–є вАФ –±–Њ–ї–µ–µ-–Љ–µ–љ–µ–µ —Б–Њ–ї–Є–і–љ–∞—П –≤–µ—Й—М. –Э–µ –Љ–Њ–ґ–µ—В API-—Д—Г–љ–Ї—Ж–Є—П –њ—А–Њ—Б—В–Њ —В–∞–Ї –≤–љ–µ–Ј–∞–њ–љ–Њ –Є—Б—З–µ–Ј–љ—Г—В—М, –Є—Е –љ–∞–±–Њ—А –њ–Њ–і–і–µ—А–ґ–Є–≤–∞—О—В –≤ —А–∞–±–Њ—В–Њ—Б–њ–Њ—Б–Њ–±–љ–Њ–Љ –≤–Є–і–µ –і–ї—П —А–∞–Ј—А–∞–±–Њ—В—З–Є–Ї–Њ–≤, –∞ –µ—Б–ї–Є –Ї–∞–Ї—Г—О-—В–Њ API-—Д—Г–љ–Ї—Ж–Є—О —Е–Њ—В—П—В —Г–њ—А–∞–Ј–і–љ–Є—В—М вАФ –Ј–∞—А–∞–љ–µ–µ —Г–≤–µ–і–Њ–Љ–ї—П—О—В –Њ–± —Н—В–Њ–Љ –≤ —Б–Њ–Њ—В–≤–µ—В—Б—В–≤—Г—О—Й–µ–є —Б—В—А–∞–љ–Є—Ж–µ –і–Њ–Ї—Г–Љ–µ–љ—В–∞—Ж–Є–Є –і–ї—П —А–∞–Ј—А–∞–±–Њ—В—З–Є–Ї–Њ–≤. API-—Д—Г–љ–Ї—Ж–Є–Є –њ–Њ–Ј–Є—Ж–Є–Њ–љ–Є—А—Г—О—В—Б—П –Ї–∞–Ї ¬Ђ–≤–µ—Й—М –і–ї—П —А–∞–Ј—А–∞–±–Њ—В—З–Є–Ї–Њ–≤¬ї, –Є —Б–Њ–Њ—В–≤–µ—В—Б—В–≤—Г—О—Й–Є–µ –ї—О–і–Є –љ–∞–і —Н—В–Є–Љ —В—А—П—Б—Г—В—Б—П. –Э–∞–±–Њ—А —Г—В–Є–ї–Є—В –љ–µ –њ–Њ–Ј–Є—Ж–Є–Њ–љ–Є—А—Г–µ—В—Б—П –Ї–∞–Ї –Є–љ—Б—В—А—Г–Љ–µ–љ—В–∞—А–Є–є –і–ї—П —А–∞–Ј—А–∞–±–Њ—В—З–Є–Ї–Њ–≤ вАФ —Б–Ї–Њ—А–µ–µ –Ї–∞–Ї –Є–љ—Б—В—А—Г–Љ–µ–љ—В –і–ї—П –∞–і–Љ–Є–љ–Є—Б—В—А–Є—А–Њ–≤–∞–љ–Є—П. –І—В–Њ-—В–Њ —П –љ–µ –њ—А–Є–њ–Њ–Љ–љ—О, —З—В–Њ–±—Л –≥–і–µ-—В–Њ MS –Ј–∞–і–Њ–Ї—Г–Љ–µ–љ—В–Є—А–Њ–≤–∞–ї–Є (–љ–∞ –њ—А–∞–≤–∞—Е –і–Њ–Ї—Г–Љ–µ–љ—В–∞ –і–ї—П —А–∞–Ј—А–∞–±–Њ—В—З–Є–Ї–Њ–≤, –∞ –љ–µ —Е–µ–ї–њ–∞ –і–ї—П —О–Ј–µ—А–Њ–≤, –Њ—В–љ–Њ—Б—П—Й–µ–≥–Њ—Б—П –Ї –Ї–Њ–љ–Ї—А–µ—В–љ–Њ–є –≤–µ—А—Б–Є–Є –њ—А–Њ–і—Г–Ї—В–∞), —З—В–Њ –µ—Б—В—М —В–∞–Ї–Њ–є-—В–Њ –љ–∞–±–Њ—А —Г—В–Є–ї–Є—В, —З—В–Њ –Њ–љ–Є –Њ–±–µ—Й–∞—О—В —Б–Њ—Е—А–∞–љ—П—В—М –њ–Њ –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В–Є –љ–µ–Є–Ј–Љ–µ–љ–љ—Л–Љ, —З—В–Њ —Б–Љ—Л—Б–ї –Ї–ї—О—З–Є–Ї–Њ–≤ –Ї–Њ–Љ–∞–љ–і–љ–Њ–є —Б—В—А–Њ–Ї–Є –≥–∞—А–∞–љ—В–Є—А–Њ–≤–∞–љ–љ–Њ –љ–µ –њ–Њ–Љ–µ–љ—П–µ—В—Б—П –≤ –Ї–∞–Ї–Њ–є-—В–Њ —Б–ї–µ–і—Г—О—Й–µ–є –≤–µ—А—Б–Є–µ–є. –Я–Њ—Н—В–Њ–Љ—Г API-—Д—Г–љ–Ї—Ж–Є–Є –љ–∞–Љ–љ–Њ–≥–Њ –ї—Г—З—И–µ.

–Т–Њ-–≤—В–Њ—А—Л—Е, –њ–Њ–Љ–Є–Љ–Њ —Б–Є—В—Г–∞—Ж–Є–Є, –Ї–Њ–≥–і–∞

taskkill –Њ—В—Б—Г—В—Б—В–≤—Г–µ—В, –њ–Њ—В–Њ–Љ—Г —З—В–Њ –µ–≥–Њ —Г–±—А–∞–ї–Є –Є–Ј —И—В–∞—В–љ–Њ–є –њ–Њ—Б—В–∞–≤–Ї–Є –Ю–° –≤–Њ–Њ–±—Й–µ, –Љ–Њ–ґ–µ—В –Њ–Ї–∞–Ј–∞—В—М—Б—П, —З—В–Њ

taskkill –Њ—В—Б—Г—В—Б—В–≤—Г–µ—В –љ–∞ –Ї–Њ–љ–Ї—А–µ—В–љ–Њ–є –Љ–∞—И–Є–љ–µ. –≠—В–Њ –Љ–Њ–ґ–µ—В —Б–ї—Г—З–Є—В—М—Б—П –њ–Њ —А–∞–Ј–љ—Л–Љ –њ—А–Є—З–Є–љ–∞–Љ: –Ї–∞–Ї–∞—П-–ї–Є–±–Њ –Ї–∞—Б—В–Њ–Љ–љ–∞—П —Б–±–Њ—А–Ї–∞ –Ю–°, –љ–∞–њ—А–Є–Љ–µ—А –Љ–Є–љ–Є–Љ–∞–ї–Є—Б—В–Є—З–µ—Б–Ї–∞—П, –Ї–Њ—В–Њ—А–∞—П –Ј–∞–≥—А—Г–ґ–∞–µ—В—Б—П —Б CD, –ї–Є–±–Њ –њ–Њ—В–Њ–Љ—Г —З—В–Њ –Ї—В–Њ-—В–Њ (—З—В–Њ-—В–Њ) —Г–і–∞–ї–Є–ї —Н—В—Г –њ—А–Њ–≥—А–∞–Љ–Љ—Г –љ–µ–њ—А–µ–і–љ–∞–Љ–µ—А–µ–љ–љ–Њ, –∞ SFP –Њ—В–Ї–ї—О—З—С–љ, –ї–Є–±–Њ –њ–Њ—В–Њ–Љ—Г, —З—В–Њ –µ—С —Г–і–∞–ї–Є–ї–Є –љ–∞–Љ–µ—А–µ–љ–љ–Њ (–љ–µ –≤–∞–ґ–љ–Њ, –≤ —Б–Є–ї—Г –Ї–∞–Ї–Є—Е –њ—А–Є—З–Є–љ). –° API-—Д—Г–љ–Ї—Ж–Є–µ–є —В–∞–Ї–Њ–≥–Њ –њ—А–Њ–Є–Ј–Њ–є—В–Є –љ–µ –Љ–Њ–ґ–µ—В.

–Т-—В—А–µ—В—М–Є—Е, —Н—В–Њ—В —Б–њ–Њ—Б–Њ–± –љ–µ —Б—А–∞–±–Њ—В–∞–µ—В, –µ—Б–ї–Є –≤ –њ–∞–њ–Ї–µ —Б –њ—А–Њ–≥—А–∞–Љ–Љ–Њ–є –Њ–Ї–∞–ґ–µ—В—Б—П –і—А—Г–≥–Њ–є

taskkill. –Т —Н—В–Њ–Љ —Б–ї—Г—З–∞–µ –±—Г–і–µ—В –≤—Л–Ј–≤–∞–љ –љ–µ —Б–Є—Б—В–µ–Љ–љ—Л–є

taskkill, –∞ —В–Њ—В, –Ї–Њ—В–Њ—А—Л–є –ї–µ–ґ–Є—В —А—П–і–Њ–Љ (–Ї–Њ—В–Њ—А—Л–є –Љ–Њ–ґ–µ—В –ї–Є–±–Њ –і–µ–ї–∞—В—М —З—В–Њ-—В–Њ —Б–Њ–≤–µ—А—И–µ–љ–љ–Њ –і—А—Г–≥–Њ–µ, –ї–Є–±–Њ –≤–Њ–Њ–±—Й–µ –љ–µ —А–∞–±–Њ—В–∞—В—М). –Ъ–Њ–љ–µ—З–љ–Њ, –µ—Б–ї–Є –њ—А–Њ–≥—А–∞–Љ–Љ–∞ –ґ–Є–≤—С—В –≤ —Б–≤–Њ—С–Љ —Б–Њ–±—Б—В–≤–µ–љ–љ–Њ–Љ –Ї–∞—В–∞–ї–Њ–≥–µ, –Є —Г—Б—В–∞–љ–∞–≤–ї–Є–≤–∞–µ—В—Б—П –≤ Program Files, –≤–µ—А–Њ—П—В–љ–Њ—Б—В—М —В–∞–Ї–Њ–≥–Њ —Б–ї—Г—З–∞—П вАФ –Љ–∞–ї–∞ (–љ–Њ –Њ—Б—В–∞—С—В—Б—П), –љ–Њ –µ—Б—В—М —В–∞–Ї–Њ–є –њ–Њ–њ—Г–ї—П—А–љ—Л–є —Д–Њ—А–Љ–∞—В —А–∞—Б–њ—А–Њ—Б—В—А–∞–љ–µ–љ–Є—П –њ—А–Њ–≥—А–∞–Љ–Љ –Ї–∞–Ї ¬Ђportable¬ї, –Ї–Њ–≥–і–∞ –њ—А–Њ–≥—А–∞–Љ–Љ–∞ –љ–µ —В—А–µ–±—Г–µ—В —Г—Б—В–∞–љ–Њ–≤–Ї–Є, –Ї–Њ–≥–і–∞ –Њ–љ–∞ –Љ–Њ–ґ–µ—В –ґ–Є—В—М –≤ –ї—О–±–Њ–є –њ–∞–њ–Ї–µ, –Ї–Њ–≥–і–∞ –Њ–љ–∞ —А–∞—Б–њ—А–Њ—Б—В—А–∞–љ—П–µ—В—Б—П –≤ –≤–Є–і–µ –Њ–і–љ–Њ–≥–Њ EXE-—Д–∞–є–ї–∞, –љ–µ –Ј–∞–≤–Є—Б—П—Й–µ–≥–Њ –Њ—В –Ї–∞–Ї–Є—Е-–ї–Є–±–Њ —А—П–і–Њ–Љ –ї–µ–ґ—П—Й–Є—Е —Д–∞–є–ї–Њ–≤. –Т —Н—В–Њ–Љ —Б–ї—Г—З–∞–µ –≤–µ—А–Њ—П—В–љ–Њ—Б—В—М —В–∞–Ї–Њ–≥–Њ –Њ—В–Ї–∞–Ј–∞ —Б–Є–ї—М–љ–Њ —Г–≤–µ–ї–Є—З–Є–≤–∞–µ—В—Б—П: –µ—Б–ї–Є —В–≤–Њ–є EXE-—Д–∞–є–ї –Љ–Њ–ґ–µ—В –ї–µ–ґ–∞—В—М –≥–і–µ —Г–≥–Њ–і–љ–Њ (–Є –њ—А–Є —Н—В–Њ–Љ –±—Г–і–µ—В —А–∞–±–Њ—В–∞—В—М), –Љ–Њ–ґ–µ—В –Ј–∞–њ—А–Њ—Б—В–Њ –Њ–Ї–∞–Ј–∞—В—М—Б—П, —З—В–Њ —А—П–і–Њ–Љ –ї–µ–ґ–Є—В –Ї–∞–Ї–Њ–є-—В–Њ –ї–µ–≤—Л–є

taskkill. –Э–∞–њ—А–Є–Љ–µ—А, —П —З–∞—Б—В–Њ –њ—А–Њ—И—Г –Љ–љ–µ —Б–Ї–Є–љ—Г—В—М –Ї–∞–Ї—Г—О-–љ–Є–±—Г–і—М –њ—А–Њ–≥—А–∞–Љ–Љ–Ї—Г –Є–Ј –і—А—Г–≥–Њ–є –≤–µ—А—Б–Є–Є –Ю–°, —З—В–Њ–±—Л —З—В–Њ-—В–Њ –њ—А–Њ–≤–µ—А–Є—В—М/–њ–Њ–Є—Б—Б–ї–µ–і–Њ–≤–∞—В—М. –Ш –≤–Њ—В –±—Г–і–µ—В —Г –Љ–µ–љ—П –ї–µ–ґ–∞—В—М –љ–∞ —А–∞–±–Њ—З–µ–Љ —Б—В–Њ–ї–µ taskkill –Є–Ј 64-–±–Є—В–љ–Њ–є Win7, –Є –Ї–Є–љ—Г —П –љ–∞ —А–∞–±–Њ—З–Є–є —Б—В–Њ–ї —В–≤–Њ–є exe-—И–љ–Є–Ї, –Є —Б–ї—Г—З–Є—В—Б—П –Њ–±–ї–Њ–Љ. –Р —Б API-—Д—Г–љ–Ї—Ж–Є–є —В–∞–Ї–Є–µ —Б—Ж–µ–љ–∞—А–Є–Є –Є—Б–Ї–ї—О—З–µ–љ—Л.

–Т-—З–µ—В–≤—С—А—В–≤—Л—Е, –Њ—З–µ–љ—М –ї–µ–≥–Ї–Њ –Љ–Њ–ґ–µ—В –±—Л—В—М, —З—В–Њ —В–≤–Њ—С –њ—А–Њ–≥—А–∞–Љ–Љ–∞ –±—Г–і–µ—В –Ј–∞–њ—Г—Й–µ–љ–Њ –≤ –Є–Ј–Љ–µ–љ—С–љ–љ–Њ–Љ –Њ–Ї—А—Г–ґ–µ–љ–Є–Є –Є–ї–Є —Б–∞–Љ–∞ –Є–Ј–Љ–µ–љ–Є—В —Б–≤–Њ—С –Њ–Ї—А—Г–ґ–µ–љ–Є–µ. –Х—Б–ї–Є –±–Њ–ї–µ–µ –Ї–Њ–љ–Ї—А–µ—В–љ–Њ, —В–Њ —А–µ—З—М –Є–і—С—В –Њ –њ–µ—А–µ–Љ–µ–љ–љ—Л—Е –Њ–Ї—А—Г–ґ–µ–љ–Є—П. –Х—Б–ї–Є –µ—Й—С –±–Њ–ї–µ–µ –Ї–Њ–љ–Ї—А–µ—В–љ–Њ вАФ –Њ –њ–µ—А–µ–Љ–µ–љ–љ–Њ–є –Њ–Ї—А—Г–ґ–µ–љ–Є—П

PATH. –Ш–Љ–µ–љ–љ–Њ —Н—В–∞ –њ–µ—А–µ–Љ–µ–љ–љ–∞—П –Њ–Ї—А—Г–ґ–µ–љ–Є—П –Є—Б–њ–Њ–ї—М–Ј—Г–µ—В—Б—П, –Ї–Њ–≥–і–∞ –Ј–∞–њ—Г—Б–Ї–∞–µ—В—Б—П –њ—А–Њ—Ж–µ—Б—Б, –њ–Њ–ї–љ—Л–є –њ—Г—В—М –Ї –Ї–Њ—В–Њ—А–Њ–Љ—Г –љ–µ —Г–Ї–∞–Ј–∞–љ. Windows –±—Г–і–µ—В –Є—Б–Ї–∞—В—М –Є—Б–њ–Њ–ї–љ—П–µ–Љ—Л–є —Д–∞–є–ї –≤ –Љ–µ—Б—В–∞—Е, –њ–µ—А–µ—З–Є—Б–ї–µ–љ–љ—Л—Е –≤ –њ–µ—А–µ–Љ–µ–љ–љ–Њ–є –Њ–Ї—А—Г–ґ–µ–љ–Є—П

PATH. –Х—Б–ї–Є –Љ–Њ–і–Є—Д–Є—Ж–Є—А–Њ–≤–∞—В—М –Ј–љ–∞—З–µ–љ–Є–µ —Н—В–Њ–є –њ–µ—А–µ–Љ–µ–љ–љ–Њ–є, —В–≤–Њ–є –Ј–∞–њ—Г—Б–Ї

taskkill –Њ–±–ї–Њ–Љ–∞–µ—В—Б—П вАФ¬†—Б–Є—Б—В–µ–Љ–∞ –љ–µ —Б–Љ–Њ–ґ–µ—В –µ–≥–Њ –љ–∞–є—В–Є.

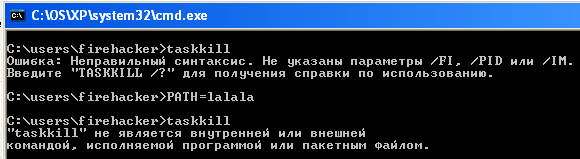

–Т–Њ—В —П –≤ –Ї–Њ–Љ–∞–љ–і–љ–Њ–є —Б—В—А–Њ–Ї–µ –≤—Л–Ј—Л–≤–∞—О

taskkill (–Њ–љ –≤—Л–Ј—Л–≤–∞–µ—В—Б—П –Є –≤—Л–≤–Њ–і–Є—В —Б–≤–Њ–є –Ї—А–∞—В–Ї–Є–є —Е–µ–ї–њ), –Ј–∞—В–µ–Љ –њ–Њ—А—З—Г

PATH –Є –њ—Л—В–∞—О—Б—М –≤—В–Њ—А–Њ–є —А–∞–Ј –≤—Л–Ј–≤–∞—В—М

taskkill вАФ¬†—Б–Є—Б—В–µ–Љ–∞ —Г–ґ–µ –љ–µ –Љ–Њ–ґ–µ—В –µ–≥–Њ –љ–∞–є—В–Є:

- running_taskkill_with_spoiled_path_envvar.png (8.8 –Ъ–±) –Я—А–Њ—Б–Љ–Њ—В—А–Њ–≤: 4184

–Х—Б–ї–Є –Є–Ј —Н—В–Њ–≥–Њ –Њ–Ї–љ–∞ –Ї–Њ–Љ–∞–љ–і–љ–Њ–є —Б—В—А–Њ–Ї–Є –Ј–∞–њ—Г—Б—В–Є—В—М —В–≤–Њ—О –њ—А–Њ–≥—А–∞–Љ–Љ—Г, –Њ–љ–∞ —В–∞–Ї–Є–Љ –ґ–µ –Њ–±—А–∞–Ј–Њ–Љ –љ–µ —Б–Љ–Њ–ґ–µ—В –Ј–∞–њ—Г—Б—В–Є—В—М

taskkill. –Ш, –µ—Б—В–µ—Б—В–≤–µ–љ–љ–Њ, –Є—Б–њ–Њ—А—В–Є—В—М –њ–µ—А–µ–Љ–µ–љ–љ—Г—О –Њ–Ї—А—Г–ґ–µ–љ–Є—П

PATH –Љ–Њ–ґ–љ–Њ –љ–µ —В–Њ–ї—М–Ї–Њ –Є–Ј –Ї–Њ–Љ–∞–љ–і–љ–Њ–є —Б—В—А–Њ–Ї–Є: —Н—В–Њ –Љ–Њ–ґ–µ—В —Б–і–µ–ї–∞—В—М –ї—О–±–Њ–є –њ—А–Њ—Ж–µ—Б—Б, –Ї–Њ—В–Њ—А—Л–є –Ј–∞–њ—Г—Б—В–Є—В —В–≤–Њ–є –њ—А–Њ—Ж–µ—Б—Б, –Є–ї–Є —Н—В–Њ –Љ–Њ–ґ–µ—В —Б–і–µ–ї–∞—В—М —Б–∞–Љ –ґ–µ —В–≤–Њ–є –њ—А–Њ—Ж–µ—Б—Б, –Є–ї–Є —Н—В–Њ –Љ–Њ–ґ–µ—В –±—Л—В—М —Б–і–µ–ї–∞–љ–Њ –≥–ї–Њ–±–∞–ї—М–љ–Њ –љ–∞ —Г—А–Њ–≤–љ–µ –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї—П –Ю–° –Є–ї–Є –љ–∞ —Г—А–Њ–≤–љ–µ –≤—Б–µ–є –Ю–°. –Р —Б API-—Д—Г–љ–Ї—Ж–Є–µ–є –њ–Њ–і–Њ–±–љ—Л–µ —Б—Ж–µ–љ–∞—А–Є–Є –Њ—В–Љ–µ–љ—П—О—В—Б—П –≤ –њ—А–Є–љ—Ж–Є–њ–µ.

–Т-–њ—П—В—Л—Е, –Ј–∞–њ—Г—Б–Ї

taskkill вАФ —Н—В–Њ –≤—Б—С —В–∞–Ї–Є —Б–Њ–Ј–і–∞–љ–Є–µ (–њ–Њ—А–Њ–ґ–і–µ–љ–Є–µ) –љ–Њ–≤–Њ–≥–Њ –њ—А–Њ—Ж–µ—Б—Б–∞. –°–Є—В—Г–∞—Ж–Є—П, –Ї–Њ–≥–і–∞ –і–ї—П –Ј–∞–≤–µ—А—И–µ–љ–Є—П –Њ–і–љ–Њ–≥–Њ –њ—А–Њ—Ж–µ—Б—Б–∞ –љ—Г–ґ–љ–Њ —Б–љ–∞—З–∞–ї–∞ –њ–Њ—А–Њ–і–Є—В—М –љ–Њ–≤—Л–є –і—А—Г–≥–Њ–є, –њ–Њ–њ–∞—Е–Є–≤–∞–µ—В –і–µ–±–Є–ї–Є–Ј–Љ–Њ–Љ. –Т —Г—Б–ї–Њ–≤–Є—П—Е –љ–µ–і–Њ—Б—В–∞—В–Ї–∞ —А–µ—Б—Г—А—Б–Њ–≤ (–љ–∞–њ—А–Є–Љ–µ—А –њ–∞–Љ—П—В–Є —П–і—А–∞ –Є–ї–Є —Б–≤–Њ–±–Њ–і–љ—Л—Е —Б—В—А–∞–љ–Є—Ж –≤ —Д–∞–є–ї–µ –њ–Њ–і–Ї–∞—З–Ї–Є) –Љ–Њ–ґ–µ—В —Б–ї—Г—З–Є—В—М—Б—П —В–∞–Ї, —З—В–Њ –Ј–∞–њ—Г—Б–Ї –љ–Њ–≤–Њ–≥–Њ –њ—А–Њ—Ж–µ—Б—Б–∞ –Њ–±–ї–Њ–Љ–Є—В—Б—П. –Ш –Љ—Л –њ–Њ–ї—Г—З–Є–Љ —Б–Є—В—Г–∞—Ж–Є—О, –Ї–Њ–≥–і–∞ –Є–Ј-–Ј–∞ –љ–µ—Е–≤–∞—В–Ї–Є –њ–∞–Љ—П—В–Є –Љ—Л –љ–µ –Љ–Њ–ґ–µ–Љ —Г–љ–Є—З—В–Њ–ґ–Є—В—М –њ—А–Њ—Ж–µ—Б—Б, —Е–Њ—В—П –Ї–∞–Ї —А–∞–Ј —Г–±–Є–є—Б—В–≤–Њ –њ—А–Њ—Ж–µ—Б—Б–∞ –Њ—Б–≤–Њ–±–Њ–і–Є–ї–Њ –±—Л –њ–∞–Љ—П—В—М –Є —Б–Є–ї—М–љ–Њ —Г–ї—Г—З—И–Є–ї–Њ –±—Л –њ–Њ–ї–Њ–ґ–µ–љ–Є–µ –і–µ–ї. –≠—В–Њ –≤—Б—С —А–∞–≤–љ–Њ, —З—В–Њ —Г–Љ–µ—А–µ—В—М –Њ—В –ґ–∞–ґ–і—Л, –њ–Њ—В–Њ–Љ—Г —З—В–Њ –љ–µ –±—Л–ї–Њ —Б–Є–ї –Њ—В–Ї—А—Л—В—М —А–Њ—В (–∞ –љ–µ –њ–Њ—В–Њ–Љ—Г, —З—В–Њ –љ–µ –±—Л–ї–Њ –≤–Њ–і—Л). –Ш —В–∞–Ї–∞—П —Б–Є—В—Г–∞—Ж–Є—П (–Ї–Њ–≥–і–∞ –љ–µ —Е–≤–∞—В–∞–µ—В —Б–Є—Б—В–µ–Љ–љ—Л—Е —А–µ—Б—Г—А—Б–Њ–≤ –љ–∞ –Ј–∞–њ—Г—Б–Ї

taskkill) –≤–Њ–≤—Б–µ –љ–µ –љ–∞–і—Г–Љ–∞–љ–љ–∞—П –Є –љ–µ —В–∞–Ї–∞—П –љ–µ—А–µ–∞–ї–Є—Б—В–Є—З–љ–∞—П, –Ї–∞–Ї –Љ–Њ–≥–ї–Њ –±—Л –њ–Њ–Ї–∞–Ј–∞—В—М—Б—П, вАФ —П –±—Г–Ї–≤–∞–ї—М–љ–Њ –Љ–µ—Б—П—Ж –љ–∞–Ј–∞–і —Б –љ–µ–є —Б—В–∞–ї–Ї–Є–≤–∞–ї—Б—П. –ѓ —А–µ–љ–і–µ—А–Є–ї –≤–Є–і–µ–Њ –Ї

—Н—В–Њ–Љ—Г –њ–Њ—Б—В—Г –≤ Sony Vegas-–µ, –Є –Њ–љ –љ–Є–Ї–∞–Ї –љ–µ –Љ–Њ–≥ –µ–≥–Њ –Њ—В—А–µ–љ–і–µ—А–Є—В—М вАФ –≥–Њ–≤–Њ—А–Є–ї ¬Ђ–љ–µ–і–Њ—Б—В–∞—В–Њ—З–љ–Њ –њ–∞–Љ—П—В–Є¬ї. –Я—А–Є —В–Њ–Љ, —З—В–Њ –Љ–µ—Б—В–∞ –≤ —Д–∞–є–ї–∞—Е –њ–Њ–і–Ї–∞—З–Ї–Є –±—Л–ї–Њ —П–≤–љ–Њ –љ–∞–≤–∞–ї–Њ–Љ, –±—Л–ї–Њ –њ–Њ–љ—П—В–љ–Њ, —З—В–Њ –љ–µ —Е–≤–∞—В–∞–µ—В –љ–µ –њ–∞–Љ—П—В–Є –Ї–∞–Ї —В–∞–Ї–Њ–≤–Њ–є, –∞ —Б–≤–Њ–±–Њ–і–љ–Њ–≥–Њ —А–µ–≥–Є–Њ–љ–∞ –≤ –∞–і—А–µ—Б–љ–Њ–Љ –њ—А–Њ—Б—В—А–∞–љ—Б—В–≤–µ. –Я–Њ–≥—Г–≥–ї–Є–≤ –њ–Њ —В–Њ—З–љ–Њ–є —Б—В—А–Њ–Ї–µ —Б —Б–Њ–Њ–±—Й–µ–љ–Є–µ–Љ –Њ–± –Њ—И–Є–±–Ї–µ, —П –љ–∞—В–Ї–љ—Г–ї—Б—П –љ–∞ —В–Њ, —З—В–Њ –ї—О–і–Є —А–µ—И–∞—О—В —Н—В—Г –њ—А–Њ–±–ї–µ–Љ—Г, –і–Њ–±–∞–≤–ї—П—П EXE-—Д–∞–є–ї—Г –∞—В—А–Є–±—Г—В

LargeAddressAware (—Б –њ–Њ–Љ–Њ—Й—М—О editbin). –Э–Њ –Љ–љ–µ-—В–Њ –±—Л–ї–Њ —Б–Њ–≤–µ—А—И–µ–љ–љ–Њ –Њ—З–µ–≤–Є–і–љ–Њ, —З—В–Њ –Њ–і–љ–Њ –ї–Є—И—М –і–Њ–±–∞–≤–ї–µ–љ–Є–µ —Н—В–Њ–≥–Њ –∞—В—А–Є–±—Г—В–∞ –≤–Њ–Њ–±—Й–µ –љ–Є–Ї–∞–Ї –љ–µ –≤–ї–Є—П–µ—В –љ–∞ —Б–Є—В—Г–∞—Ж–Є—О: –љ–∞–ї–Є—З–Є–µ —Н—В–Њ–≥–Њ –∞—В—А–Є–±—Г—В–∞ —Б—Л–≥—А–∞–µ—В —Б–≤–Њ—О —А–Њ–ї—М —В–Њ–ї—М–Ї–Њ –≤ —В–Њ–Љ —Б–ї—Г—З–∞–µ, –µ—Б–ї–Є —Б–Є—Б—В–µ–Љ–∞ –±—Л–ї–∞ –Ј–∞–≥—А—Г–ґ–µ–љ–∞ —Б –Ї–ї—О—З–Њ–Љ

/3GB –≤ boot.ini. –° —Н—В–Є–Љ –Ї–ї—О—З–Њ–Љ —П–і–µ—А–љ–∞—П —З–∞—Б—В—М –Р–Я –≤—Б–µ—Е –њ—А–Њ—Ж–µ—Б—Б–Њ–≤ –±—Г–і–µ—В —Г–ґ–∞—В–∞ –і–Њ 1 GB, –∞ –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї—М—Б–Ї–∞—П —З–∞—Б—В—М вАФ —А–∞—Б—И–Є—А–µ–љ–∞ –і–Њ 3 GB. –Т–њ—А–Њ—З–µ–Љ, –±–µ–Ј —Н—В–Њ–≥–Њ –∞—В—А–Є–±—Г—В–∞ —Б–Є—Б—В–µ–Љ–∞ –≤—Б—С —А–∞–≤–љ–Њ –±—Г–і–µ—В –≤—Л–і–µ–ї—П—В—М –њ—А–Њ—Ж–µ—Б—Б—Г –њ–∞–Љ—П—В—М —В–Њ–ї—М–Ї–Њ –Є–Ј –љ–Є–ґ–љ–Є—Е –і–≤—Г—Е –≥–Є–≥–∞–±–∞–є—В, –Є —В–Њ–ї—М–Ї–Њ —Б –љ–∞–ї–Є—З–Є–µ–Љ –∞—В—А–Є–±—Г—В–∞

LargeAddressAware –њ—А–Њ—Ж–µ—Б—Б —Б–Љ–Њ–ґ–µ—В –≤–Њ—Б–њ–Њ–ї—М–Ј–Њ–≤–∞—В—М—Б—П 3-—Е –≥–Є–≥–∞–±–∞–є—В–љ—Л–Љ –Р–Я.

–Я–Њ—Н—В–Њ–Љ—Г —П –≤—Л–і–∞–ї Vegas-—Г —Н—В–Њ—В –∞—В—А–Є–±—Г—В, –∞ –≤ boot.ini –і–Њ–±–∞–≤–Є–ї –Ї–ї—О—З

/3GB. –≠—В–Њ –Є–Љ–µ–ї–Њ –≤–њ–Њ–ї–љ–µ –Њ–ґ–Є–і–∞–µ–Љ—Л–є –Є—Б—Е–Њ–і: —Б–Є—Б—В–µ–Љ–∞ –≤–Њ–Њ–±—Й–µ –љ–µ –Љ–Њ–≥–ї–∞ –Ј–∞–≥—А—Г–Ј–Є—В—М—Б—П. –Ъ–ї—О—З

/3GB –Ј–∞—Б—В–∞–≤–ї—П–ї —П–і–µ—А–љ—Г—О —З–∞—Б—В—М –Р–Я —Б—В–Є—Б–љ—Г—В—Б—П —Б 2 –У–± –і–Њ 1 –У–± (—В–Њ –µ—Б—В—М —Г–Љ–µ–љ—М—И–Є—В—М—Б—П –≤–і–≤–Њ–µ), –∞ —Г –Љ–µ–љ—П –≤ —В–Њ –ґ–µ —Б–∞–Љ–Њ–µ –≤—А–µ–Љ—П –±—Л–ї –≤–Ї–ї—О—З–µ–љ —А–µ–ґ–Є–Љ PAE, –≤–Ї–ї—О—З–µ–љ–Є–µ –Ї–Њ—В–Њ—А–Њ–≥–Њ —Б–Є–ї—М–љ–Њ —Г–≤–µ–ї–Є—З–Є–≤–∞–µ—В —А–∞–Ј–Љ–µ—А —В–∞–±–ї–Є—Ж PDE/PTE (—А–∞–Ј–Љ–µ—А —Б—В—А—Г–Ї—В—Г—А PTE –Є PDE –±–µ–Ј PAE вАФ 4 –±–∞–є—В–∞, –≤ —А–µ–ґ–Є–Љ–µ PAE вАФ –≤ –і–≤–∞ —А–∞–Ј–∞ –±–Њ–ї—М—И–µ вАФ 8 –±–∞–є—В). –†–µ–ґ–Є–Љ PAE –±—Л–ї –Ј–∞–і–µ–є—Б—В–≤–Њ–≤–∞–љ –Є–Ј-–Ј–∞ —В–Њ–≥–Њ, —З—В–Њ –±—Л–ї –≤–Ї–ї—О—З–µ–љ –∞–њ–њ–∞—А–∞—В–љ—Л–є DEP. –Я–Њ—Н—В–Њ–Љ—Г —П –Њ—В—А–µ–і–∞–Ї—В–Є—А–Њ–≤–∞–ї boot.ini —В–∞–Ї, —З—В–Њ–±—Л –Ј–∞–њ—Г—Б—В–Є—В—М—Б—П —Б

/3GB –љ–Њ –±–µ–Ј DEP (–∞ –Ј–љ–∞—З–Є—В –±–µ–Ј –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є—П PAE).

–Ч–∞–≥—А—Г–Ј–Є—В—М—Б—П —Б–Љ–Њ–≥, –љ–Њ —Б–Є–ї—М–љ–Њ —Н—В–Њ –љ–µ –њ–Њ–Љ–Њ–≥–ї–Њ: –±–Њ–ї—М—И–∞—П —З–∞—Б—В—М –і—А–∞–є–≤–µ—А–Њ–≤ –љ–µ —Б–Љ–Њ–≥–ї–∞ –Ј–∞–≥—А—Г–Ј–Є—В—М—Б—П, —А–∞–±–Њ—В–∞–ї —В–Њ–ї—М–Ї–Њ –Њ—Б–љ–Њ–≤–љ–Њ–є –Љ–Њ–љ–Є—В–Њ—А, –і–∞ –Є —В–Њ –≤ —А–µ–ґ–Є–Љ–µ 640√Ч480 ¬Ј 16 —Ж–≤–µ—В–Њ–≤, –љ–Њ —З—В–Њ —Б–∞–Љ–Њ–µ –≥–ї–∞–≤–љ–Њ–µ: —П –љ–µ –Љ–Њ–≥—Г –Ј–∞–њ—Г—Б—В–Є—В—М –њ—А–∞–Ї—В–Є—З–µ—Б–Ї–Є –љ–Є—З–µ–≥–Њ, –њ–Њ—В–Њ–Љ—Г —З—В–Њ —П–і—А—Г –љ–µ —Е–≤–∞—В–∞–ї–Њ –њ–∞–Љ—П—В–Є. –С—Л–ї–Њ —П—Б–љ–Њ, —З—В–Њ –Њ –Т–µ–≥–∞—Б–µ –љ–µ –њ—А–Є—Е–Њ–і–Є—В—Б—П –Є –Љ–µ—З—В–∞—В—М, –Є –љ—Г–ґ–љ–Њ –±—Л–ї–Њ —Е–Њ—В—П –±—Л –≤–µ—А–љ—Г—В—М boot.ini –≤ –Є—Б—Е–Њ–і–љ–Њ–µ —Б–Њ—Б—В–Њ—П–љ–Є–µ. –Э–Њ –љ–µ —В—Г—В-—В–Њ –±—Л–ї–Њ: –љ–µ —Е–≤–∞—В–∞–ї–Њ —А–µ—Б—Г—А—Б–Њ–≤, —З—В–Њ–±—Л –Ј–∞–њ—Г—Б—В–Є—В—М —В–Њ—В –ґ–µ Notepad. –Э—Г–ґ–љ–Њ –±—Л–ї–Њ –њ–Њ–Ј–∞–≤–µ—А—И–∞—В—М —А–∞–Ј–љ—Л–µ —Д–Њ–љ–Њ–≤—Л–µ –њ—А–Њ—Ж–µ—Б—Б—Л, –љ–Њ –љ–µ —Е–≤–∞—В–∞–ї–Њ —А–µ—Б—Г—А—Б–Њ–≤ –і–∞–ґ–µ –љ–∞ —В–Њ, —З—В–Њ–±—Л –Њ—В–Ї—А—Л—В—М –Ф–Є—Б–њ–µ—В—З–µ—А –Ј–∞–і–∞—З –њ–Њ Ctrl+Alt+Del. –£–і–∞–≤–∞–ї–Њ—Б—М –Њ—В–Ї—А—Л—В—М

cmd, –љ–Њ –Є –Њ—В—В—Г–і–∞ taskkill –љ–µ –Љ–Њ–≥ –љ–Њ—А–Љ–∞–ї—М–Њ –Ј–∞–њ—Г—Б—В–Є—В—М—Б—П вАФ –љ–µ —Е–≤–∞—В–Є–ї–Њ –њ–∞–Љ—П—В–Є. –Ґ–µ–Љ –љ–µ –Љ–µ–љ–µ–µ, —П —В–Њ–≥–і–∞ –Ї–∞–Ї-—В–Њ –≤—Л–Ї—А—Г—В–Є–ї—Б—П –Є —Б—Г–Љ–µ–ї —Г–±–Є—В—М explorer, –њ–Њ—Г–±–Є–≤–∞—В—М taskkill-–Њ–Љ –≤—Б–µ —Д–Њ–љ–Њ–≤—Л–µ –њ—А–Њ—Ж–µ—Б—Б—Л, –Ј–∞–њ—Г—Б—В–Є—В—М –±–ї–Њ–Ї–љ–Њ—В –Є –Њ—В—А–µ–Љ–Њ–љ—В–Є—А–Њ–≤–∞—В—М boot.ini. –Р –≤–Є–і–µ–Њ –≤ –Є—В–Њ–≥–µ –њ—А–Є—И–ї–Њ—Б—М 5 —З–∞—Б–Њ–≤ —А–µ–љ–і–µ—А–Є—В—М –љ–∞ –≤–Є—А—В—Г–∞–ї—М–љ–Њ–є –Љ–∞—И–Є–љ–µ (–Ї–Њ—В–Њ—А–∞—П –ї–µ–≥–Ї–Њ –Ј–∞–≥—А—Г–Ј–Є–ї–∞—Б—М —Б –Ї–ї—О—З–Њ–Љ

/3GB).

–Т-—И–µ—Б—В—Л—Е, –Ј–∞–њ—Г—Б–Ї

taskkill –Љ–Њ–ґ–µ—В –±—Л—В—М –њ–Њ–њ—А–Њ—Б—В—Г –Ј–∞–њ—А–µ—Й—С–љ –∞–і–Љ–Є–љ–Є—Б—В—А–∞—В–Є–≤–љ—Л–Љ–Є –љ–∞—Б—В—А–Њ–є–Ї–∞–Љ–Є –љ–∞ —Ж–µ–ї–µ–≤–Њ–є –Љ–∞—И–Є–љ–µ.

–Т-—Б–µ–і—М–Љ—Л—Е, —Г–љ–Є—З—В–Њ–ґ–µ–љ–Є–µ –њ—А–Њ—Ж–µ—Б—Б–∞ —Б –њ–Њ–Љ–Њ—Й—М—О —В–∞–Ї –Є–ї–Є –Є–љ–∞—З–µ –≤—Л–њ–Њ–ї–љ—П–µ—В—Б—П —Б –њ–Њ–Љ–Њ—Й—М—О API-—Д—Г–љ–Ї—Ж–Є–Є

TerminateProcess вАФ –љ–µ –≤–∞–ґ–љ–Њ, –Ї—В–Њ –±—Г–і–µ—В –µ—О –њ–Њ–ї—М–Ј–Њ–≤–∞—В—М—Б—П (—В–≤–Њ—С –њ—А–Є–ї–Њ–ґ–µ–љ–Є–µ —Б–∞–Љ–Њ –Є–ї–Є –≤—Л–Ј–≤–∞–љ–љ—Л–є –Є–Љ

taskkill). –≠—В–Њ–є —Д—Г–љ–Ї—Ж–Є–Є –љ—Г–ґ–µ–љ —Е–µ–љ–і–ї –њ—А–Њ—Ж–µ—Б—Б–∞. –Э–Њ –љ–µ –њ—А–Њ—Б—В–Њ —Е–µ–љ–і–ї, –∞ —Е–µ–љ–і–ї —Б –њ—А–∞–≤–Њ–Љ –љ–∞ —Г–љ–Є—З—В–Њ–ґ–µ–љ–Є–µ –њ—А–Њ—Ж–µ—Б—Б–∞. –Я—А–Є —Н—В–Њ–Љ –њ–Њ—А–Њ–ґ–і–∞—О—Й–Є–є –њ—А–Њ—Ж–µ—Б—Б –њ—А–Є —Б–Њ–Ј–і–∞–љ–Є–Є –і–Њ—З–µ—А–љ–µ–≥–Њ –Љ–Њ–ґ–µ—В –њ–Њ–ї—Г—З–Є—В—М —Е–µ–љ–і–ї —Б –њ–Њ–ї–љ—Л–Љ –љ–∞–±–Њ—А–Њ–Љ –њ—А–∞–≤. –°—В–Њ—А–Њ–љ–љ–Є–є –ґ–µ –њ—А–Њ—Ж–µ—Б—Б (–Ї–Њ—В–Њ—А—Л–є –љ–µ –њ–Њ—А–Њ–ґ–і–∞–ї —Г–±–Є–≤–∞–µ–Љ—Л–є) –≤—Л–љ—Г–ґ–і–µ–љ –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞—В—М

OpenProcess, —З—В–Њ–±—Л –Є–Ј PID-–∞ –њ–Њ–ї—Г—З–Є—В—М —Е–µ–љ–і–ї. –Х—Б—В—М –≤–µ—А–Њ—П—В–љ–Њ—Б—В—М, —З—В–Њ –њ—А–Є –Ј–∞–њ—А–Њ—Б–µ —Е–µ–љ–і–ї–∞ –њ–Њ PID-—Г, –Є–Ј-–Ј–∞ –Њ—Б–Њ–±–µ–љ–љ–Њ—Б—В–µ–є –∞–і–Љ–Є–љ–Є—Б—В—А–∞—В–Є–≤–љ–Њ–є –љ–∞—Б—В—А–Њ–є–Ї–Є –Ї–Њ–љ–Ї—А–µ—В–љ–Њ–є –Љ–∞—И–Є–љ—Л, –њ—А–Њ—Ж–µ—Б—Б taskkill –љ–µ —Б–Љ–Њ–ґ–µ—В –њ–Њ–ї—Г—З–Є—В—М —Е–µ–љ–і–ї —Б –њ—А–∞–≤–Њ–Љ –љ–∞ —Г–љ–Є—З—В–Њ–ґ–µ–љ–Є–µ –њ—А–Њ—Ж–µ—Б—Б–∞ –ґ–µ—А—В–≤—Л, –∞ –Ј–љ–∞—З–Є—В –Є –љ–µ —Б–Љ–Њ–ґ–µ—В –µ–≥–Њ —Г–±–Є—В—М. –Я—А–Є —Н—В–Њ–Љ –њ—А–Њ—Ж–µ—Б—Б-—А–Њ–і–Є—В–µ–ї—М —В–∞–Ї–Њ–є —Е–µ–љ–і–ї –Љ–Њ–ґ–µ—В –Є–Љ–µ—В—М –Ј–∞–њ—А–Њ—Б—В–Њ.

–Э—Г –Є –≤ –Ї–Њ–љ—Ж–µ-–Ї–Њ–љ—Ж–Њ–≤, —В–Њ –µ—Б—В—М –≤-–≤–Њ—Б—М–Љ—Л—Е: –µ—Б—В—М –љ–µ–Ї–Њ—В–Њ—А–∞—П –Ї–Њ–Љ–±–Є–љ–∞—Ж–Є—П 3-–≥–Њ –Є 4-–≥–Њ –њ—Г–љ–Ї—В–Њ–≤, –Ї–Њ—В–Њ—А–∞—П –≤—Л–≥–ї—П–і–Є—В –і–∞–ґ–µ –±–Њ–ї–µ–µ —А–µ–∞–ї–Є—Б—В–Є—З–љ–Њ–є, —З–µ–Љ —Н—В–Є –њ—Г–љ–Ї—В—Л –≤ –Њ—В–і–µ–ї—М–љ–Њ—Б—В–Є. –Э–µ –Њ–±—П–Ј–∞—В–µ–ї—М–љ–Њ, —З—В–Њ–±—Л –ї–µ–≤—Л–є

taskkill –ї–µ–ґ–∞–ї –≤ –њ–∞–њ–Ї–µ —Б –љ–∞—И–µ–є –њ—А–Њ–≥—А–∞–Љ–Љ–Њ–є. –Э–µ –Њ–±—П–Ј–∞—В–µ–ї—М–љ–Њ –њ–Њ—А—В–Є—В—М –њ–µ—А–µ–Љ–µ–љ–љ—Г—О –Њ–Ї—А—Г–ґ–µ–љ–Є—П

PATH. –Ю–љ–∞ –Љ–Њ–ґ–µ—В –±—Л—В—М –≤–њ–Њ–ї–љ–µ –Ј–∞–Ї–Њ–љ–љ–Њ –Є–Ј–Љ–µ–љ–µ–љ–∞ –њ–Њ—Б–ї–µ —Г—Б—В–∞–љ–Њ–≤–Ї–Є –Ї–∞–Ї–Њ–≥–Њ-—В–Њ —Б–Њ—Д—В–∞ —В–∞–Ї, —З—В–Њ –±—Г–і–µ—В –≤–Ї–ї—О—З–∞—В—М –Ї–∞–Ї—Г—О-—В–Њ –і–Є—А–µ–Ї—В–Њ—А–Є—О, –≤ –Ї–Њ—В–Њ—А–Њ–є –±—Г–і–µ—В –ї–µ–ґ–∞—В—М –Ї–∞–Ї–∞—П-—В–Њ –ї–µ–≤–∞—П

taskkill –Ї–∞–Ї–Њ–≥–Њ-—В–Њ —Б—В–Њ—А–Њ–љ–љ–µ–≥–Њ —Б–Њ—Д—В–∞. –Э–∞–њ—А–Є–Љ–µ—А —Г –Љ–µ–љ—П —В–∞–Ї –њ–Њ—Б–ї–µ —Г—Б—В–∞–љ–Њ–≤–Ї–Є

cygwin-–∞ –≤

PATH –і–Њ–±–∞–≤–Є–ї—Б—П –Ї–∞—В–∞–ї–Њ–≥ —Б cygwin-–Њ–≤—Б–Ї–Є–Љ–Є –±–Є–љ–∞—А–љ–Є–Ї–∞–Љ–Є (ls, cat, grep, ps), –њ—А–Є —Н—В–Њ–Љ cygwin-–Њ–≤—Б–Ї–Є–є –±–Є–љ–∞—А–љ–Є–Ї

link (—Б–Њ–Ј–і–∞—О—Й–Є–є —Б—Б—Л–ї–Ї–Є —Г—А–Њ–≤–љ—П —Д–∞–є–ї–Њ–≤–Њ–є —Б–Є—Б—В–µ–Љ—Л) –њ–µ—А–µ–Ї—А—Л–ї Microsoft-–Њ–≤—Б–Ї–Є–є –ї–Є–љ–Ї–µ—А

link (–Є–Ј —Б–Њ—Б—В–∞–≤–∞ Visual Studio –Є–ї–Є Platform SDK), –∞ cygwin-–Њ–≤—Б–Ї–Є–є –±–Є–љ–∞—А–љ–Є–Ї

find –њ–µ—А–µ–Ї—А—Л–ї —Б–Є—Б—В–µ–Љ–љ—Л–є (—И—В–∞—В–љ—Л–є) –±–Є–љ–∞—А–љ–Є–Ї

find. Cygwin –і–µ–ї–∞–ї–Є –Њ—В–љ—О–і—М –љ–µ –і—Г—А–∞–Ї–Є, –Є, —В–µ–Љ –љ–µ –Љ–µ–љ–µ–µ, –Љ—Л –њ–Њ–ї—Г—З–Є–ї–Є —В–∞–Ї–Њ–є –Ї–Њ–љ—Д–ї–Є–Ї—В –Є–Љ—С–љ. –Р –≥–і–µ –≥–∞—А–∞–љ—В–Є—П, —З—В–Њ –Ї–∞–Ї–Њ–є-–љ–Є–±—Г–і—М —Б–Њ—Д—В –љ–µ –њ—А–Є—В–∞—Й–Є—В —Б–≤–Њ–є taskkill, —Г–±–Є–≤–∞—О—Й–Є–є –Ї–∞–Ї—Г—О-—В–Њ —Б–≤–Њ—О –Ј–∞–і–∞—З—Г –≤ —В–µ—А–Љ–Є–љ–∞—Е —Н—В–Њ–≥–Њ —Б–Њ—Д—В–∞, –љ–∞ –Ї–Њ–Љ–њ—М—О—В–µ—А –Є –љ–µ –Ј–∞–љ–µ—Б—С—В –Ї–∞—В–∞–ї–Њ–≥, –≤ –Ї–Њ—В–Њ—А–Њ–Љ —Н—В–∞ –њ—А–Њ–≥—А–∞–Љ–Љ–∞ –ї–µ–ґ–Є—В, –≤

PATH? –Р —Б –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є–µ–Љ API-—Д—Г–љ–Ї—Ж–Є–Є —В–∞–Ї–Њ–є —Б—Ж–µ–љ–∞—А–Є–є –Є—Б–Ї–ї—О—З—С–љ.